Theses and Practica

The following pages show open topics for practica, bachelor and master theses, sorted by application fields. We will be happy to provide information on further open topics upon request. Topics can be completed either in English or German.

Open Topics

21.10.2025 |

Biological&Medical Data

06.10.2025 |

Natural Language Processing,

Misc.

06.10.2025 |

Biological&Medical Data

06.10.2025 |

Biological&Medical Data

06.10.2025 |

Biological&Medical Data

24.06.2025 |

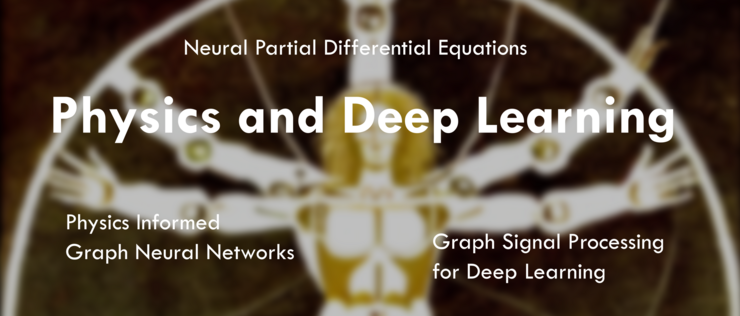

Physics & Deep Learning,

Ecosystems

15.05.2025 |

Physics & Deep Learning,

Ecosystems

08.05.2025 |

Security

06.05.2025 |

Security

06.05.2025 |

Security

06.05.2025 |

Security

06.05.2025 |

Security

30.04.2025 |

Security

17.02.2025 |

Natural Language Processing

30.01.2025 |

Security

30.01.2025 |

Security

22.01.2025 |

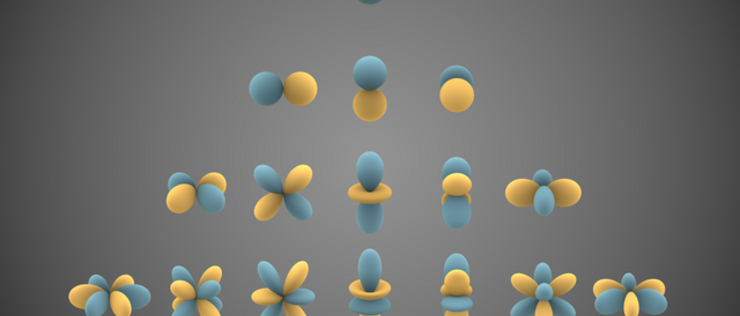

Physics & Deep Learning,

Ecosystems